DE LA RÉSIDENCE INTERFACE JUSQU’À « CONDUITE ALGORITHMIQUE » : UN PARCOURS À DOUBLE-SENS

[La Voiture sans conducteur dans l’au-delà, impression numérique (2017).]

/////

Le texte qui suit se décline en deux parties : d’abord une entrevue en profondeur avec l’artiste François Quévillon, tout premier à avoir pris part à la résidence Interface art-science de Sporobole ; suit une courte réflexion sur l’exposition « Conduite algorithmique », présentée à Sporobole en novembre 2018.

De la résidence Interface jusqu’à « Conduite algorithmique » : un parcours à double-sens

En 2014, François Quévillon amorçait la toute première résidence de ce qui allait devenir le programme Interface de Sporobole et qui soutient chaque année un projet art-science. En étroite collaboration avec l’Université de Sherbrooke, le programme se déploie avec la collaboration de nombreux chercheurs, affiliés à une diversité de domaines de recherche allant de l’ingénierie sonore, à la neuroscience et de la microbiologie au traitement des matériaux tel que le verre. Ce ne sont que quelques exemples. Dans le cas de François Quévillon, cartographie sonore et apprentissage machine l’ont amené à développer tout un corpus d’œuvres qui ont fait l’objet d’une exposition BétaLab à Sporobole en novembre dernier. Intitulée « Conduite algorithmique », l’exposition rassemblait plus d’une dizaine d’œuvres : installation, dispositif interactif, impression numérique et vidéos, et offrait une vaste vue d’ensemble des recherches menées par l’artiste ces quatre dernières années.

/////

En ce début d’année 2019, je me suis entretenue avec François Quévillon qui m’a parlé de son expérience de résidence et du travail autour des œuvres présentées à Sporobole.

– Peux-tu parler un peu de l’amorce du projet : d’où vient l’idée de travailler sur l’apprentissage machine et la cartographie sonore ? Comment ces deux aspects se mettent-ils en relation ?

Tout d’abord, il faut dire que le Groupe Necotis (Neurosciences Computationnelles et Traitement Intelligent des Signaux) a été parmi les premiers à manifester un intérêt envers le projet de recherche-création, mais j’ai continué à faire des rencontres car il n’y avait pas de chercheur dans le groupe de disponible à ce moment et aussi pour voir l’ensemble des possibilités. Donc j’ai rencontré des chercheurs dans différents domaines : en microfluidique, en nano caractérisation, en biophotonique, en robotique aussi. Un processus qui a pris plusieurs mois et qui devait aussi inclure un chercheur en sciences humaines à l’origine. Apprentissage machine et cartographie sonore… Ça a vraiment émergé d’une part avec le groupe de recherche Necotis, après avoir rencontré Louis Commère, un étudiant qui s’intéressait à la sonification de réseaux de neurones tant biologiques qu’artificiels, et un autre chercheur qui était au doctorat, Sean Wood, qui travaillait sur l’effet « cocktail party ». Disons qu’il y a cent personnes dans une pièce qui parlent, il s’agirait d’isoler une voix pour celles et ceux qui n’arrivent pas à suivre une conversation lorsque c’est très bruyant. Donc comment isoler une voix dans l’espace et le bruit… Je trouvais que la sonification de neurones avait souvent été abordée artistiquement pour que ce soit notre projet de recherche commun : il y a des artistes qui y travaillent depuis les années 1960, qui ont sonifiés l’activité du cerveau, du corps en général, etc. Alors on a plutôt fait l’inverse : plutôt que de sonifier un réseau de neurones, pourquoi ne pas générer une structure à partir de sons, ce qui nous a donné l’idée de la cartographie sonore. Puis avec Sean Wood, qui travaillait sur l’effet « cocktail party », on s’est dit : plutôt que d’isoler une voix, comment pourrait-on créer une machine qui n’écoute pas les humains. Il s’agissait vraiment de s’éloigner d’une dynamique de surveillance, d’imposer des obstacles à la machine pour qu’elle ne réussisse pas à percevoir une voix humaine. On a donc essayé de faire quelque chose à la croisée de nos pratiques respectives tout en étant décalé de celles-ci. Généralement je travaille plus sur des problématiques liées à l’image, et là c’est un projet plutôt axé sur le son qui a émergé… C’est un peu ce qui a déterminé le projet.

– Ça a commencé par une recherche autour de la question du son avec la résidence, si je comprends bien, puis, dans un deuxième temps, c’est allé vers l’apprentissage machine…

Oui, déjà le groupe de recherche travaille en intelligence artificielle et développe, entre autres, des systèmes robotiques. Ils travaillent beaucoup sur la substitution sensorielle aussi. Louis Commère par exemple travaille en ce moment sur la sonification d’objets à partir de capteurs 3D ou de caméras : il s’agit de numériser un objet en 3D et de le traduire en son. Puis il y a Etienne Richan, avec qui j’ai travaillé plus récemment, dont le processus est un peu l’inverse : il génère des textures à partir de sons. Dans les deux cas, ils travaillent sur les moyens d’aider les personnes qui ont des handicaps visuels ou auditifs, par exemple traduire des informations sonores en images ou l’inverse pour les malvoyants, donc traduire – d’une certaine manière – l’espace en son. Facebook, Google et d’autres mènent aussi des recherches en intelligence artificielle où ils mettent de l’avant les bienfaits pour les personnes handicapées et leur impact social positif, mais certains aspects de ces technologies peuvent aussi être utilisés pour le ciblage publicitaire ou à des fins moins nobles. Bien sûr, nous souhaitons tous aider les gens qui ont des difficultés à entendre ou à voir mais ces recherches peuvent servir à autre chose.

– Oui cela peut être exploité pour le bien ou pour le mal…

Oui voilà…

Il y a une dimension critique et poétique, mais aussi conceptuelle, technique et esthétique avec ce projet, que l’on essayait d’équilibrer. Ils ont une belle sensibilité artistique dans le groupe [Necotis]. Je leur ai fait découvrir certains artistes, mais il y en avait qu’ils connaissaient déjà, surtout en lien avec l’intelligence artificielle qui, depuis quelques années, est devenu un sujet populaire dans le monde de l’art. C’était vraiment le début d’une certaine vague en 2015, entre autres avec Deep Dream de Google, puis beaucoup de projets de « morphing » psychédéliques, de réseaux de neurones artificiels qui commençaient à émerger. Je leur ai parlé, entre autres, de l’œuvre « The Giver of Names » de David Rokeby qui date du début des années 1990. Un objet était posé sur un socle, avec une caméra qui l’observait, puis le système générait du contenu poétique à partir de ce qu’il percevait. C’est un projet qui était déjà très avancé pour l’époque.

Un autre élément qui a orienté notre projet au départ c’était le lieu dans lequel nous allions travailler, à Sporobole. Tu connais l’espace : il y a plein de caméras de surveillance autour du centre. C’est un espace très surveillé et on ne sait pas à qui appartiennent certaines caméras et si elles fonctionnent vraiment. Comme tu sais, juste au-dessus de la porte de Sporobole, il y a une énorme caméra de surveillance : je pense qu’elle appartient à la ville, peut-être le service de police. Il y en a d’autres dans la ruelle où se trouve les restaurants, les bars, puis d’autres près des condos. Il y a au moins une vingtaine de caméras de surveillance autour de Sporobole. Il y avait donc un peu de questionnements par rapport à ça aussi, les enjeux qui entourent la surveillance, et comment faire un dispositif qui ne soit pas un système de contrôle et de surveillance justement : ça a aussi orienté nos recherches.

– Et de quelle manière vous avez utilisé les caméras autour de Sporobole ?

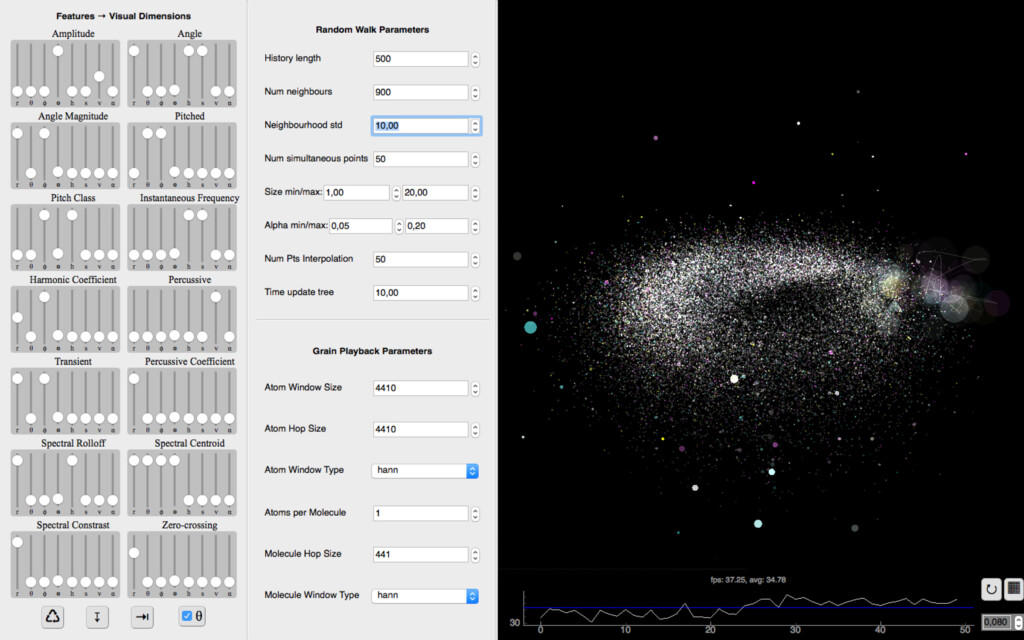

On n’a pas utilisé les caméras mais on pensait par exemple faire une cartographie sonore du lieu qui s’éloignerait de l’idée de surveillance, c’est-à-dire qui ne capte pas les conversations, ne surveille pas les voitures, mais fragmente et brouille le fil des événements. Puis on a décidé de capter du bruit à partir du toit du bâtiment, mais en faisant de très courtes captations discontinues. Finalement on a mis tellement de bâtons dans les roues au système qu’à la fin c’est juste du bruit, du chaos sonore. Sa manière de reconstituer une composition est aussi très incontrôlée. Le système fonctionne avec un algorithme de marche aléatoire, un processus stochastique. Disons que tu arrives à un coin de rue, tu peux aller à gauche, à droite ou tout droit. C’est un peu le même principe, il y a un choix de direction aléatoire à l’intérieur d’un réseau de chemins définis. On lui imposait des contraintes à partir de particules de sons classifiées de différentes manières : basses fréquences, hautes fréquences, haut volume, bas volume, aspect percussif du son, etc. Ce qui constituait un espace… L’interface du système comprend douze paramètres : l’amplitude, l’angle, la hauteur, la classe de hauteur, les fréquences, les harmoniques, l’aspect percussif, l’aspect transitoire, le spectre, le centroïde du spectre, le contraste spectral et les passages à zéro. Tous ces paramètres-là peuvent être cartographiés. Les sons similaires tendent à se regrouper, mais on peut aussi dire au système de fonctionner plutôt par contrastes, puis de déterminer une structure rythmique à partir de ça…

– Et c’est un programme qui exécute ça ?

Oui, c’est un programme qu’on a développé ensemble. Donc après avoir fait la cartographie sonore de Sporobole, j’ai essayé différentes choses qui me semblaient présenter autant un côté poétique qu’une validité scientifique. Comme par exemple de générer un nuage à partir de bruits d’orages. J’ai extrait quatre jours d’enregistrements d’orages sur Internet et plutôt que d’utiliser des échantillons très courts d’un dixième de seconde j’ai utilisé des secondes complètes qui sont cartographiées selon différentes caractéristiques : les bruits de tonnerre se retrouvent au même endroit, ensuite on a la pluie, différentes fréquences de pluies, plus on monte plus ça devient des hautes fréquences, puis plus on descend plus ce sont des basses fréquences… Puis il y a une ligne qui vient générer une composition infinie. Tu as vu le nuage, c’est toujours une configuration fixe, on tourne autour mais le nuage ne bouge pas… Ici, pour « Murmurations », où l’on entend les cris des oiseaux, je changeais les paramètres : l’amplitude était remplacée par l’aspect percussif, ensuite l’aspect percussif devenait le spectre, donc ça change la position des points, puis en reconfigurant les points ça change les connexions possibles entre les points. Donc la composition qui est générée par les bruits d’oiseaux dépend de la disposition des informations dans cet espace.

– Et ce système fonctionne de manière aléatoire ?

C’est un aléa contrôlé, ou plutôt, orienté, et c’est ce que j’aime : je sais à peu près ce qui se peut se passer, mais c’est toujours surprenant : ce n’est pas complètement aléatoire, tout est très structuré mais évolue de manière imprévisible.

– Ça évoque beaucoup le son d’une radio, lorsqu’on cherche un poste…

Exactement ! Oui, tu n’es pas la première qui me dit ça. C’est vraiment un type différent de spatialisation, l’environnement sonore de Sporobole est traduit dans une géométrie non euclidienne. C’est comme faire du « mapping » dans un espace elliptique sphérique, avec le centre et différents axes, ce qui permet aussi de réaliser divers types de compositions.

– Donc il s’agit de trois exercices de cartographie sonore qui ont résulté de la résidence… ?

Oui… Celui dont je viens de parler c’était le premier et le plus chaotique, le plus bruyant : on ne comprend absolument rien de ce qui se passe parce qu’on voulait vraiment s’éloigner le plus possible d’une dynamique de surveillance.

[Interface graphique du prototype développé lors de la résidence.]

– C’est une mise en échec de la dynamique de surveillance ?

En quelque sorte, le système tente de faire du sens à partir de micro fragments bruités.

Pour revenir à la résidence… Au début il y a différents paramètres qui ont fait que cela a été long avant que ça démarre. Et je voulais sortir de ma zone de confort. J’aurais sans doute pu continuer ce que je faisais avec « Dérive » et travailler en numérisation 3D avec des instruments plus sophistiqués. Une autre piste était la salle blanche où il y a, entre autres, des microscopes à force atomique. J’aurais pu y travailler pour créer des images avec des microscopes, mais c’est comme un cliché lorsqu’on pense aux relations art-science. Je voulais aller vers un territoire que je n’avais pas abordé encore. Peut-être travailler plus le son, puis travailler avec le contexte, le lieu, Sporobole, le bruit, la surveillance, différents enjeux par rapport à la collecte de données et aux procédures algorithmiques. Ce qui me fait penser : récemment j’ai lu que quelqu’un a demandé les enregistrements de son dispositif Alexa d’Amazon, et ils ont envoyé les enregistrements d’une autre personne, 1700 enregistrements dans une autre maison ! Il y a de plus en plus de systèmes comme celui-là, pensons aux voitures… C’est d’ailleurs ce qui m’a amené vers le projet qui a suivi. Les voitures sont des réseaux de capteurs mobiles, de plus en plus connectées et munies de systèmes « intelligents », et on ne sait pas trop où s’en vont certaines informations. Donc oui, c’est un autre enjeu qui nous intéressait avec le groupe de recherche, mais ça faisait beaucoup de couches différentes disons. Au début je ne savais pas du tout où je m’en allais avec ce projet et c’est au hasard des rencontres que cela s’est développé.

– Et au hasard des résidences qui ont suivies finalement… Parce qu’il y a eu la résidence Interface et ce qui en est ressorti, mais tu as amené tout cela ailleurs ensuite…

Oui c’est ça, on en vient au prochain projet… À La Chambre Blanche notamment, et je me suis aussi impliqué à l’UQAM dans le groupe de recherche de Jean Dubois et d’Alexandre Castonguay sur les images opératoires, un aspect qui m’intéresse depuis les débuts de ma pratique. Tu avais d’ailleurs écrit un peu là-dessus en 2012 pour ma résidence au Brésil au LABMIS : les représentations opératoires y étaient abordées et j’avais parlé du travail de Samuel Bianchini et des images qui agissent par elles-mêmes et sur lesquelles on peut aussi agir. Je suis revenu vers cela : il s’agissait donc de poursuivre ce qu’on avait développé ici durant la résidence en analyse audio, mais d’aller plus loin en analysant les images et les données du véhicule. Depuis deux ans, je fais des captations avec une caméra que j’installe sur mon pare-chocs avant. J’ai enregistré du son et des images, et comme la caméra est connectée à l’ordinateur de bord de l’auto d’autres informations se sont ajoutées : ma vitesse, les coordonnées géographiques, les vibrations de la caméra, des données provenant du moteur aussi, la température du liquide de refroidissement, etc. Vraiment une surabondance de données. Puis dans un deuxième temps, un peu sur une structure similaire, avec un algorithme de marche aléatoire et certains paramètres contrôlables, des procédures viennent déterminer le fil des événements. Il y a un lien avec « En attendant Bárðarbunga » aussi, où les données de la machine génèrent le montage filmique en temps réel. C’est une forme de visualisation des activités de la machine, alors l’idée c’était de pousser un peu plus loin ce qu’on avait réalisé et de créer une interface qui permet d’interagir avec le système.

[Captations vidéo et de données à Détroit pour Conduite algorithmique.]

– Et dans quel contexte ce projet a émergé ?

Ça a émergé lentement. J’ai commencé à travailler là-dessus en 2016 : j’avais différentes idées, et je voulais retravailler avec le groupe de recherche, mais Sean Wood partait à l’extérieur du pays pour une très longue période et Louis Commère était très occupé, donc soit je le développais par moi-même ou bien je collaborais avec une nouvelle personne. Puis j’ai rencontré un nouveau membre de Necotis en 2017, Etienne Richan, qui s’intéresse aussi à ce qui se passe dans le milieu artistique. C’est vraiment super de travailler avec lui là-dessus : ça fait à peu près un an qu’on collabore.

– Donc tu es allé le chercher après ta résidence : en mode off résidence ?

Oui, c’est ça – ou post résidence – plus d’un an suite à ma résidence chez Sporobole, il y a eu de multiples périodes de recherche : d’idées, de technologies, de collaborateur, de financement… Les véhicules autonomes, en 2015-2016, c’était vraiment ce qui commençait à soulever plein d’enjeux touchant l’intelligence artificielle, mais de manière vraiment concrète. D’ailleurs parmi les liens que je t’ai envoyés il y a la Moral Machine – une plateforme en ligne qui explore les dilemmes moraux en lien avec les véhicules autonomes. On y aborde différents problèmes liés aux systèmes d’intelligence artificielle, avec toutes sortes de questions éthiques et morales, mais aussi culturelles : face à un accident imminent, protège-t-on la vie d’un enfant ou d’une personne âgée en priorité ? Si tu es en Amérique du Nord, l’enfant est considéré plus « important » que la personne âgée, mais à certains endroits en Asie, c’est plutôt la personne âgée. La même question se pose à propos du genre, du statut social et de l’état de santé… Donc non seulement il n’y a pas vraiment de bonne réponse, mais cela varie d’un endroit du monde à l’autre. Et est-ce qu’on voudrait une voiture qui protège notre vie, ou bien la vie des gens à l’extérieur ? Et serait-ce possible de programmer cela soi-même ? Est-il acceptable de pouvoir ajuster le niveau de protection que l’on s’accorde ou que l’on accorde aux autres… ?

– Comment gérer les questions relatives à la notion de « danger » qui sont liée à la conduite…

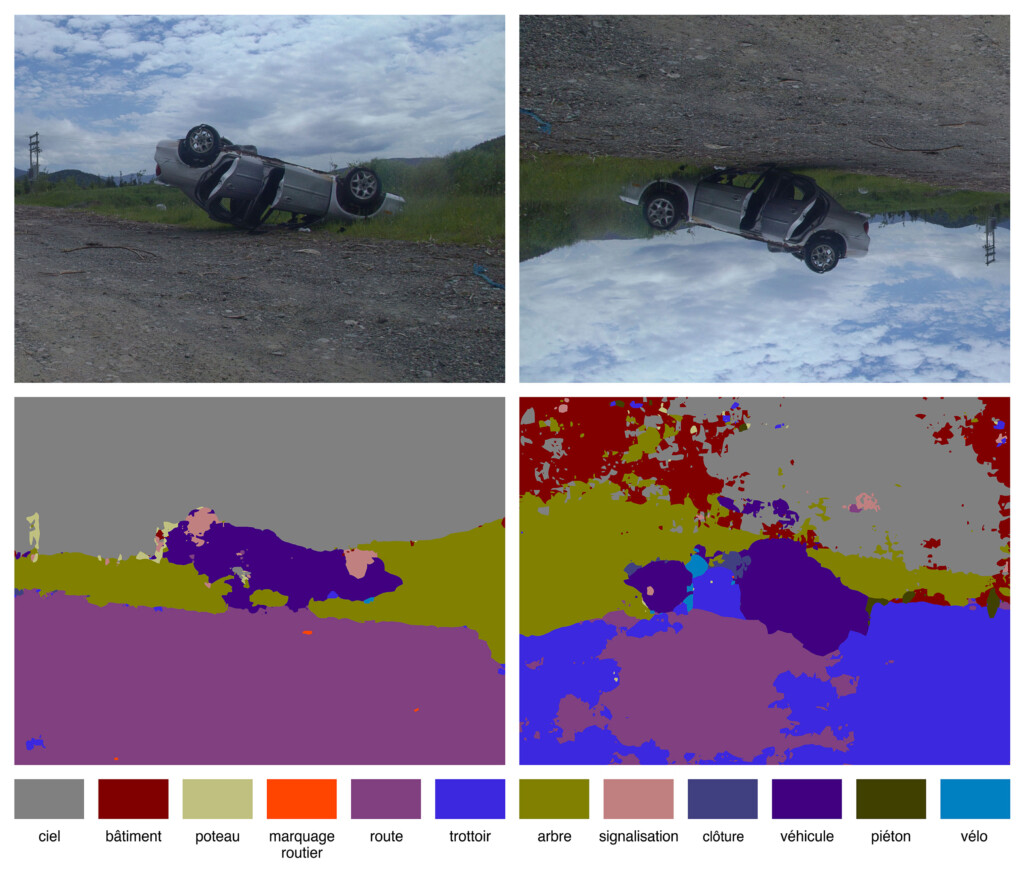

Oui, et la manière dont les systèmes sont développés aussi, bien souvent c’est en Californie ou au Royaume-Uni. Par exemple le système que j’utilise ici c’est SegNet, et il est entraîné avec des images qui diffèrent des conditions hivernales du Québec. Si je l’utilise dans un environnement enneigé, qu’est-ce qui se passe ? Il y a du blanc partout… Ou bien la nuit, qu’est-ce qu’il perçoit ? Ce qui m’amène aux compilations de « dash cams » – es-tu familière avec ça ? – c’est très populaire sur YouTube, il y en a des milliers. Toutes sortes d’accidents invraisemblables, imprévisibles, de contextes particuliers… Comme par exemple à Fort McMurray, dans un incendie de forêt, qu’est-ce qui se passe : tu as un système de vision artificielle ou un LiDAR, avec de la boucane et des projectiles qui arrivent de partout… S’il y a une inondation, par exemple, qu’est-ce qu’il voit ? Ou une tornade, un ouragan… Il y a quelques années ces vidéos provenaient surtout de Russie et d’Asie, où les conducteurs ont installé des caméras sur leur tableau de bord parce que des gens provoquaient des accidents, puis ensuite ils poursuivaient le conducteur. La caméra était un témoin oculaire au cas où un accident se produirait, pour se protéger. Autre exemple : un météore est tombé au beau milieu d’un village et le fait que ces caméras enregistrent en permanence a permis de capter le météore sous plusieurs angles différents. C’est un autre type d’images opératoires qui prennent une valeur légale et où l’on peut voir advenir l’imprévisible : des situations face auxquelles ce type de systèmes deviendraient parfois inopérants.

– Oui, bien déjà, il peut être détruit… Puis s’il ne l’est pas ce sera une captation de chaos, de confusion…

Oui… Et aussi, ce qui pourrait être intéressant, ce serait d’entraîner le système à partir de ces compilations d’enregistreurs de conduite. Donc à partir d’une vision très catastrophique du monde, puis voir ce qui se passe… Cette idée a fait émerger, non seulement l’installation interactive « Conduite algorithmique », mais aussi plusieurs éléments de la série « Manœuvres ».

[Conduite algorithmique, installation interactive (2018). Daïmôn.]

[Conduite algorithmique, installation interactive (2018). Expression.]

[Manœuvres, série de vidéos, 2017-2018.]

[Document de travail juxtaposant des vidéos de véhicules autonomes et de « dash cams » (Youtube).]

– Donc ici on parle bien d’une compilation de vidéos ? Juste pour être certaine…

Oui, c’est un document de travail. En fait, à gauche on voit différents systèmes de vision par ordinateur qui sont embarqués sur des véhicules autonomes, puis à droite ce sont des compilations de « dash cams ». Je mets simplement en contraste deux types de perception de la réalité si on veut, deux types de systèmes d’images opératoires. Cela donne l’impression, d’une part, que le monde peut être contrôlé, que les véhicules autonomes vont mieux conduire que les humains, mais en même temps ils vont se retrouver dans toutes sorte de situations où cela ne fonctionnera pas.

– Ce sera mis en échec…

Oui, comme la femme qui s’est fait renverser en Arizona par un véhicule autonome Uber, et qui est décédée. En fait c’était un cas de « faux positif » : de ce que j’ai compris le système l’a d’abord perçue comme étant un être humain, mais après coup, il s’est dit : c’est peut-être juste un sac… !

– « Peut-être juste un sac » ?! Wow !!

Oui, bien, si c’est, une roche ou un sac, ce qui nous semble assez simple à identifier résulte d’années d’expérience du monde, mais comment une caméra ou un LiDAR évalue la résistance d’un objet qui lui est inhabituel, ou s’il est vivant ou non, c’est autre chose…

– C’est quand même perturbant, parce que tu as dit le mot « peut-être » donc ça insinue qu’il y a eu doute… Ce qui signifie que la machine est en mesure de douter et s’il y a une forme de doute possible, comment se fait-il qu’elle soit « autorisée » à absorber ce doute-là ? C’est très troublant…

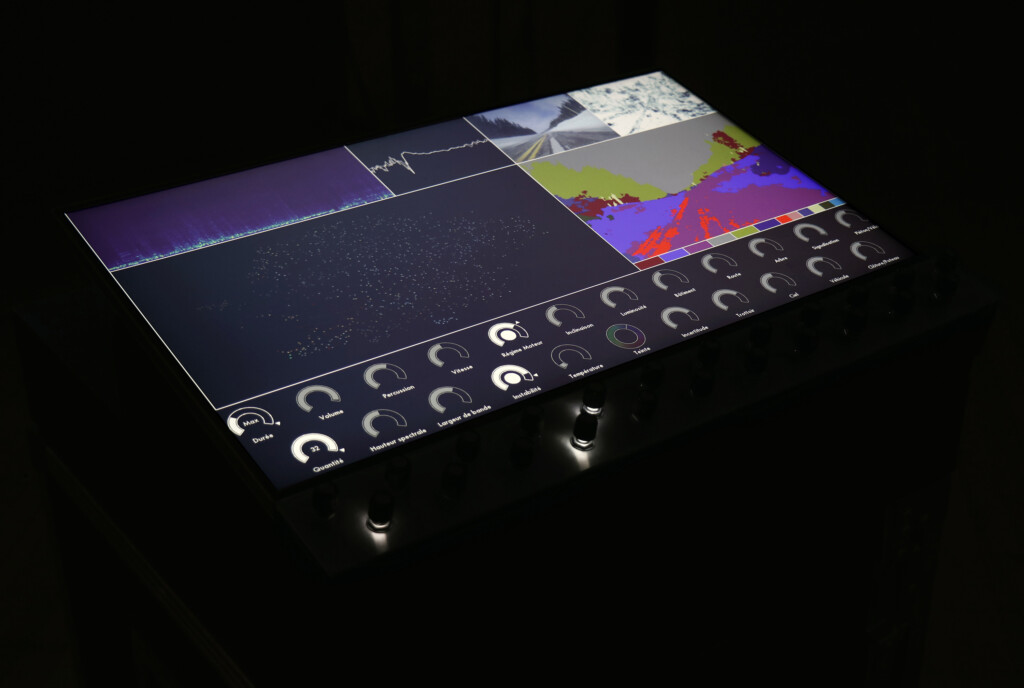

Oui… Justement en haut à droite sur le moniteur de « Conduite algorithmique », il y a aussi le modèle d’incertitude qui est généré. Il y a une classification sémantique : le ciel, la route, les arbres, les bâtiments, etc. J’ai notamment travaillé avec ce type de modèles pour l’exposition à Expression : j’ai circulé dans St-Hyacinthe et ce qu’on voit en noir, c’est ce que le système a de la difficulté à interpréter, c’est donc le modèle d’incertitude de la machine… Les fils électriques par exemple : quand il y a des lignes dans le ciel, il a de la difficulté à se dire « est-ce que c’est un bâtiment ? Est-ce le ciel ? ». Ce qui rend alors le modèle d’incertitude élevé.

[Cartographie de l’incertitude machine, installation (2019) et Le Rond-point itératif, de la série Manœuvres (2017-2018). Expression.]

[Niveaux d’incertitude, vidéo (2018). Sporobole.]

– Il n’est pas sûr si le fil délimite un volume ou si c’est du vide…

Exact, et c’est une mesure qui se veut objective, mais c’est très poétique en même temps. Aussi, si tu vas trois ou quatre fois au même endroit, pour différentes raisons, la valeur change : quelqu’un traverse-t-il la rue ? A-t-il neigé ? Ou encore, quelle est l’intensité de la lumière ambiante ? Ce n’est jamais la même valeur et, en ce sens, c’est aussi plus ou moins valide comme carte : cela représente un paradoxe intéressant… Je suis en train de développer différents projets autour de ces « phénomènes » mais je ne suis pas certain de leur statut. Quand je parle de ce dispositif [« Conduite algorithmique »], j’ai l’impression que ce n’est ni une installation interactive ni un dispositif performatif. Dans tous les cas, je le vois beaucoup comme un dispositif de recherche. Un peu comme ce que j’avais fait pendant ma résidence : c’était un dispositif [un programme informatique] qui a mené à différentes expérimentations et qui a agi comme un moteur pour réfléchir à ces questions.

– Et comment fonctionne le dispositif ?

Oui, on peut l’essayer…

– Ça se veut participatif ?

Oui, bien, soit tu le laisses aller de manière autonome ou bien tu le manipules. C’est autant une interface de contrôle qu’un système de visualisation de données. Il y a vingt-et-un paramètres et deux boutons pour le contrôle de la durée et des connexions entre les vidéos. Parmi les paramètres il y a l’amplitude du son, la vitesse du véhicule, le régime moteur, les paramètres de l’image, la température, etc. Donc tu as vingt-et-une dimensions qui sont réduites en deux dimensions : il prend les vingt-et-un paramètres puis il génère une carte, une image bidimensionnelle. C’est aussi un système d’auto-surveillance car il enregistre l’activité du véhicule, dont sa vitesse…

À propos du titre de l’oeuvre : en français c’est « Conduite algorithmique » et en anglais, « Algorithmic Drive », qui ont deux sens différents. En français c’est plus le comportement qui est mis en cause, mais en anglais nous sommes vraiment dans une sorte de pulsion – la pulsion de tout confier à des algorithmes.

[Conduite algorithmique, dispositif interactif (2018). Expression.]

– Et c’est aussi le titre de l’exposition… ?

Oui, parce que, comme je le disais, c’est un dispositif de recherche qui a généré plusieurs autres choses, qui a alimenté des réflexions et des œuvres en parallèle.

– Des œuvres qui étaient présentées dans l’exposition à Sporobole… ?

Oui… Justement il y avait aussi la caméra de recul que j’ai recontextualisée. Maintenant tous les véhicules neufs qui sont vendus au Canada possèdent une caméra à l’arrière, je ne sais pas si tu étais au courant ? Je l’ai appris il y a quelques mois : c’est devenu une loi. Ils viennent avec une caméra et c’est encore un autre type d’image opératoire. C’est un bon exemple : on ne se préoccupe pas de la valeur esthétique de ce qu’elle capte, la caméra est là pour aider à conduire, à se stationner. Je l’avais recontextualisée et installée juste en-dessous du projecteur, donc elle surveillait le dispositif, elle surveillait l’opérateur si on veut, et le petit moniteur offrait un autre point de vue sur ce qui était présenté dans la vitrine de Sporobole. Les capteurs à ultrasons habituellement installés dans les pare-chocs afin de mesurer la distance de l’objet le plus proche étaient ici positionnés sur le pied de micro, sur lequel était installé le rétroviseur. La distance des personnes s’en approchant était affichée à l’écran et un indice sonore la rendait audible. Le dispositif a son système de sécurité intégré.

[Rétroviseur, installation (2018). Sporobole.]

[Rétroviseur, installation (2018). Sporobole.]

[Le Rond-point itératif, de la série Manœuvres (2017-2018).]

– Ok oui…

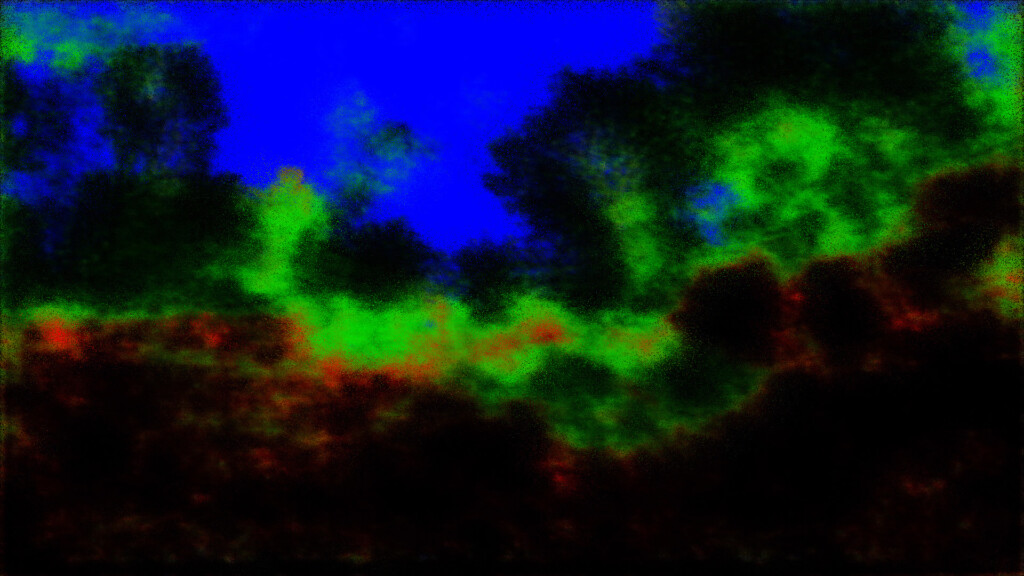

Si on en pense au cortex visuel, c’est un peu la même idée, les premières choses que le système de perception artificielle que j’ai utilisé « voit » avant de faire une classification sémantique ce sont des canaux RVB qui séparent différentes zones, le ciel, les bâtiments (et différentes choses) et la route. Puis graduellement il rajoute différentes catégories. Ici, au MNBAQ, j’ai tourné en rond, d’où le titre [« Le rond-point itératif »]. C’est une boucle de seize secondes et on voit le rond-point sous différents états : les bâtiments en rouge, la végétation en vert, mais le système hésite toujours entre la route et le trottoir parce que la chaussée est enneigée, donc est-ce la route ? Est-ce le trottoir ? Puis il reste dans un état indéfini, où il tourne en rond à l’infini parce qu’il est incertain de ce qu’il perçoit… Problème de base d’un système de vision artificielle au Québec l’hiver (rires).

Ce qui est intéressant aussi c’est que depuis deux ans j’ai eu des expositions et des résidences à différents endroits. Une résidence à Terre-Neuve par exemple où j’ai travaillé là-dessus, souvent indirectement en me rendant à destination ou à des sites faire des excursions. Puis j’ai eu mon exposition à Paved Art [à Saskatoon] où j’ai traversé une partie du Canada et des États-Unis. J’ai accumulé beaucoup de contenu dans toutes sortes de conditions…

– Je perçois aussi une esthétique ou des stratégies visuelles qui rappelle le jeu vidéo…

Oui, bien justement, une chose intéressante c’est qu’en plus d’entraîner les véhicules autonomes sur la route, on les entraîne aussi avec des jeux vidéo hyper réalistes. Il y a des simulateurs scientifiques qui existent, mais les images et les scénarios que j’ai vues étaient plutôt inintéressants, par contre tu installes le système dans Grand Theft Auto et là il se passe toute sorte de choses : le monde y est vraiment complexe, tu peux modifier la météo de manière pratiquement réaliste… Les jeux deviennent des environnements plus intéressants que les simulateurs scientifiques ou que la réalité parce qu’il y a moins de danger. C’est une autre piste que j’aimerais aborder, le lien avec les jeux vidéo…

Une autre problématique que je trouve intéressante avec ce projet, c’est l’impact environnemental des voitures. On pourrait en parler longuement, de la transformation et de l’organisation du territoire qu’elles ont engendré, jusqu’à celui issu de leurs composantes et de leur fonctionnement. Plusieurs de mes œuvres abordent les changements climatiques et des enjeux environnementaux, mais mes activités ont une empreinte écologique non-négligeable.

– Mais ce sont des constats que tu fais, que tu interprètes, ce n’est pas une démarche activiste…

Non, effectivement, mais bien entendu ça fait partie de mes préoccupations et je souhaitais révéler cette dimension de mon travail à travers ce projet. Les pratiques artistiques ont souvent un impact écologique important : le transport aérien ou routier, les constructions temporaires, les matériaux, l’équipement et leur consommation d’énergie par exemples. Je pensais intégrer des mesures de ma pollution dans le dispositif, mais je n’ai pas réussi à extraire les données de consommation de carburant ou d’émission de l’ordinateur de bord. Est-ce lié aux scandales des compagnies qui faussaient leurs résultats ou un aléa technique, je ne le sais pas… Il y a d’autres méthodes pour les calculer mais j’ai trouvé ça curieux.

– Tout cela donne à penser… Merci François !

///////////////////////////////////////////////////////////////////////////////////////////

François Quévillon explore la problématique des véhicules autonomes et de l’apprentissage machine depuis déjà plusieurs années. Une première diffusion d’une partie de ce corpus d’œuvres a d’abord eu lieu à DAÏMON en octobre 2018, puis « Conduite algorithmique » – de plus grande envergure et intégrant des créations in-situ, de même que les œuvres issues de la résidence Interface – fut présentée à Sporobole du 5 au 24 novembre 2018. « Manœuvrer l’incontrôlable » (commissaire : Éric Mattson), actuellement présentée à Expression à St-Hyacinthe – et ce, jusqu’au 21 avril – en est une autre itération : plus élaborée en terme de « scénographie » et plus complète aussi – avec « Dérive », « En attendant Bárðarbunga » et « Variations pour cordes et vents », il s’agit presque d’une rétrospective de mi-carrière.

Parmi les œuvres récentes de Quévillon, plusieurs se présentent comme des dispositifs de visionnement : les machines, écrans et projections nous prêtent leurs yeux – et ce regard emprunté est notre principale connexion avec la machine. Nous resterons au seuil de ces images enregistrées – filmées, photographiées – puis minutieusement analysées par un système chargé de surveiller le réel et ses menaces à court terme. Le plus souvent cependant, rien ne se passe. On pourrait par exemple visionner des heures et des heures de « dash cams » sans jamais y voir autre chose que la banalité du réel et ses micro événements : une mouche s’envole, un sac est déplacé par le vent, une averse commence. Derrière les yeux d’une caméra embarquée se trouve néanmoins un point de vue prioritaire. Qu’il y ait événement ou non, c’est comme être aux premières loges du spectacle. Et lorsqu’il y a spectacle, c’est presque dire qu’il y a catastrophe. Le ré-enchantement du quotidien passe rarement par l’autoroute 20. Par contre, la panne, collision, le carambolage, le capotage ou même l’explosion – punctum du spectaculaire –, là il y a à voir : « exit » l’ordre habituel des choses ; et « sortie de route » par la même occasion.

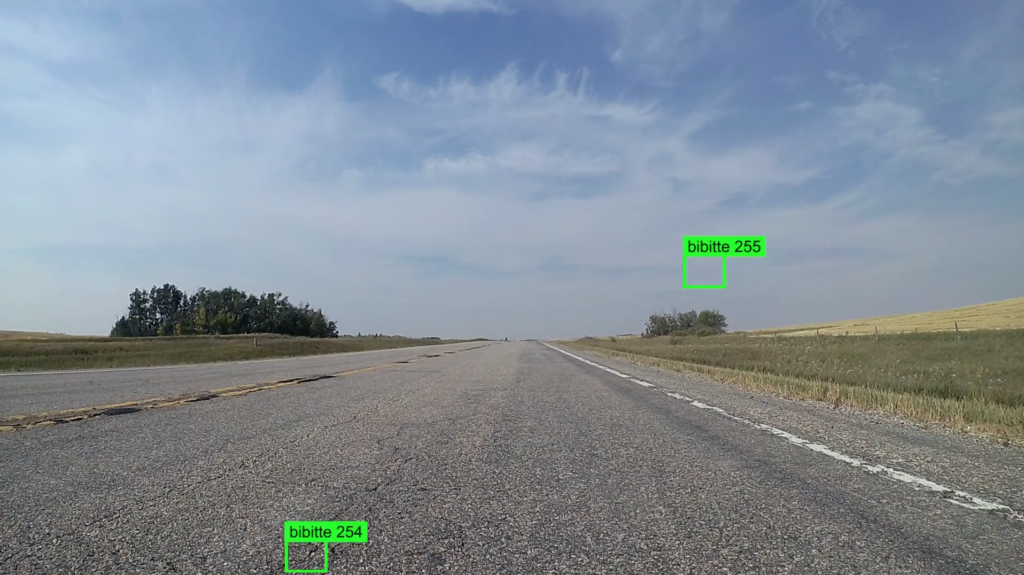

C’est ce regard – chargé d’intentions aveugles – que nous montre Quévillon avec les « Manœuvres » (2017-2018), série de six courtes vidéos qui, chacune, superpose une séquence de la réalité avec un filtre d’analyse pour caméra embarquée. Parmi ces filtres, l’un montre le système aux prises avec les intempéries qui le rendent inopérant en moins d’une minute (« Vision périphérique ») ; un autre analyse l’ensemble de son environnement en vision nocturne dans des sentiers cartographiés pour véhicules récréatifs ou randonneurs, les images analysées sont alors celles d’une situation où la voiture se trouve empêtrée sur une route inappropriée (« Égaré dans la forêt ») ; l’autre traduit visuellement la vélocité du véhicule (« La Traversée ») ; le suivant se livre à une vaine capture numérique des insectes (« Le Traqueur de bogues ») ; puis un autre nous indique la direction d’éléments qui se meuvent devant lui (« Les Flots ») ; enfin un dernier tente d’identifier les composantes qui l’entoure et n’y parvient pas aisément, puis le filtre disparaît graduellement pour nous laisser voir un rond-point (« Le Rond-point itératif »). Ce « package » de visions, avec chacune leur particularité d’analyse d’image, nous montre l’ampleur des « métanalyses » que peuvent générer, à ce jour, les véhicules autonomes. Et ce n’est que le début. Par ailleurs, ces visions involontaires portent en elles une part de poésie. Mais ça, les machines ne le savent pas – et il ne faut pas leur dire, elles pourraient se croire supérieures et vouloir auditionner pour le « Cycle des robots » d’Asimov – ce n’est pas un projet Netflix ? Je ne vois pas ce qu’ils attendent…

[Le traqueur de bogues, de la série Manœuvres (2017-2018).]

« Conduite algorithmique » est le titre de l’exposition qui était présentée à Sporobole, et c’est aussi le titre de l’œuvre-matrice de laquelle découle les autres propositions du corpus. Nous en avons déjà parlé un peu dans l’entrevue : il s’agit d’un dispositif interactif qui se présente comme un système de contrôle de séquences d’images, pouvant se moduler selon les vingt-et-un paramètres disponibles sur la console, en plus des boutons de contrôle de durée et de la quantité de vidéos sélectionnées. Concrètement la manipulation du dispositif permet de visualiser toute une typologie de séquences et de les « traiter » ou de les « mixer » à partir de paramètres d’analyse d’image, de sons et de données extraites du véhicule : durée, quantité, volume, hauteur spectrale, percussion, largeur de bande, vitesse, instabilité, régime moteur, température, inclinaison, teinte, luminosité, incertitude, bâtiment, trottoir, route, ciel, arbre, véhicule, signalisation, clôture, poteau, piéton et vélo. « Conduite algorithmique » (2018) – l’installation – permet d’exercer un contrôle à postériori sur des images qui, à priori, ne peuvent qu’être passivement monitorées. C’est une collecte sélective : une collection de séquences cataloguées. On pourrait aussi le voir comme un système d’archivage, un classement de ce qui nous échappe, de ce qui a lieu et qu’on ne voit pas la plupart du temps. C’est aussi dire qu’il existe une multitude de caméras embarquées qui sont en position de voir l’invu. Et il y en a de plus en plus : installées sur les voitures et faisant partie de l’équipement de base – obligatoire même. Or ces caméras sont connectées et les données les plus recherchées actuellement sont les données de géolocalisation. En contrepartie les automobilistes se passent difficilement du service GPS, devenu un véritable assistant personnel lors de nos déplacements. Tout cela n’est pas que l’effet d’un heureux hasard – ou malheureux, c’est selon. Notre faim capitaliste de datas est sans fin. « Notre » c’est nous, mais sans nous. C’est le capital qui œuvre à notre insu, qui est depuis longtemps sur le pilote automatique. Déresponsabilisée, la machine roule, avance et dévore, enregistre et archive, thésaurise.

Mais ce serait tourner les coins rondement et un peu vite que d’en conclure au mal absolu. Il n’est pas absolu ce mal, il est inclusif certes, mais il partage parfois sa malice avec d’autres impératifs, comme par exemple l’établissement de statistiques sur la mortalité routière via les données enregistrées. Ni bien ni mal au final : monnayable est en soi l’impératif absolu qui nous lie à ces technologies. Ce qui a valeur d’échange est à inventer constamment : créer des besoins pour vendre n’est pas nouveau. Ce qui l’est peut-être un peu plus, c’est qu’avec les données, on constate que l’information est illimitée, qu’on peut tout transformer en information d’une part, et d’autre part, que l’information elle-même se transforme constamment, à chaque millième de seconde. C’est certainement là un élément motivateur pour multiplier la présence de caméras embarquées et de dispositifs connectés sur nos véhicules – pour le meilleur et pour le pire.

Parmi les dispositifs technologiques actuellement intégrés aux voitures, tous ne sont pas connectés. Parmi ceux-ci, figure la caméra de recul. L’installation « Rétroviseur » (2018) a été créée en aménageant une rencontre entre deux éléments : le miroir qui devient l’écran – n’est-ce pas toujours un peu le cas ? – et où l’on voit ce qui est capté, c’est-à-dire soi, d’un point de vue autre. La perspective plongeante rappelle une posture omnisciente, évoquant aussi une certaine autorité – celle des technologies sur nos vies ? Remise en contexte dans l’espace de la galerie, la caméra de recul, intégrée au rétroviseur, est installée sur un trépied qui lui, est placé dans l’angle d’une projection où défile une route. Ce faisant c’est un effet de mise en abîme qui est alors mis en scène sous nos yeux : l’image montrant des marques sensées mesurer et guider la conduite, montre aussi que la route à emprunter est elle-même une image de route, et d’une certaine manière, un « behind-the-scenes » que révèle le rétroviseur.

On peut aussi se demander ce que serait « Crash » à l’ère de la récolte de datas, des « dash cams » et des véhicules autonomes. Plus de prévisibilité forcerait-elle Ballard/Cronenberg à créer des personnages plus téméraires encore ? Ou par effet inverse, ces outils permettraient-ils de planifier avec une alarmante précision l’ampleur de nos accidents – pour les Vaughan et autres Dr. Helen Remington de ce monde ? Le danger de nos parcours motorisés se jauge désormais aisément : les modèles d’incertitude et les segmentations sémantiques de données sont des moyens de mesure et d’analyse révélant une méta-vision du réel qui nous projette, en quelque sorte, dans un futur immédiat. Un futur, qui est aussi un présent, où les choses pourraient ne pas être telles que nous les avions prévues : là où la traversée d’un stationnement à étages est à la fois parfaitement empruntable et pourtant totalement impraticable, comme l’évoque la vidéo « Niveaux d’incertitude » (2018) ; et où l’envers du réel est tout aussi valable, sinon plus, que le réel lui-même, tel que le suggère « La Voiture sans conducteur dans l’au-delà » (2017). La caméra embarquée enregistre et révèle un temps sans temps, où la réalité est donnée pour multiple. Les images et analyses d’images qui constituent ce nouveau régime du regard nous conditionnent de plus en plus à voir et percevoir différemment : non seulement on peut aisément y projeter autre chose que ce qu’elles sont, mais elles contribuent – comme le dit J.G. Ballard dans le court essai documentaire Crash! (1971), qui a précédé la parution du livre en 1973 – à créer de nouvelles émotions et de nouveaux sentiments. En transformant notre manière d’appréhender la réalité, les technologies nous font voir le monde à travers leur lentille – leur monde devient le nôtre.

– Nathalie Bachand

[Crash (1996), David Cronenberg (Google Image).]

/////

Crédits photographiques : François Quévillon.